Discourse Gap Analysis: Was sichtbar macht, was Talkshows verschweigen

- Steffen Konrath

- 9. Dez. 2025

- 6 Min. Lesezeit

Eine Talkshow über Meinungsfreiheit. Fünf kluge Gäste diskutieren eine Stunde lang, ob man in Deutschland noch frei sprechen kann. Am Ende bleibt ein Gefühl: Irgendetwas fehlt. Aber was genau?

Discourse Gap Analysis ist eine Methode, die genau diese Frage systematisch beantwortet. Statt nur zu analysieren, was gesagt wurde, untersucht sie, was nicht gesagt wurde – und warum das wichtig ist.

Dieser Beitrag erklärt die Methodik, zeigt einen konkreten Benchmark und demonstriert die Anwendung anhand unserer Analyse der Markus-Lanz-Sendung vom 27. November 2025.

Was ist Discourse Gap Analysis und warum brauche ich sie?

TL;DR: Discourse Gap Analysis misst die Differenz zwischen dem theoretischen Möglichkeitsraum einer Debatte und dem, was tatsächlich diskutiert wird – und bewertet die Relevanz der Lücken.

Belege:

Jedes Diskursthema hat einen theoretischen Möglichkeitsraum: alle Perspektiven, Argumente, Akteure und Lösungsansätze, die potenziell relevant wären. Die tatsächliche Diskussion deckt davon nur einen Teil ab.

Die Differenz zwischen Möglichkeitsraum und tatsächlichem Diskurs ist die narrative Lücke. Sie umfasst systematische Auslassungen, die oft aufschlussreicher sind als das Gesagte.

Klassische Diskursanalyse fragt: "Was wurde gesagt und wie?" Discourse Gap Analysis fragt zusätzlich: "Was wurde nicht gesagt – und wer profitiert davon?"

Anwendungsfall: Eine Sendung über "Wer traut sich nicht mehr zu sprechen?" besteht ausschließlich aus Menschen, die sehr viel sprechen. Das ist keine moralische Kritik – es ist eine strukturelle Beobachtung, die ohne eine systematische Lückenanalyse unsichtbar bleibt.

Wie funktioniert die Methodik konkret?

TL;DR: Die Analyse vergleicht den tatsächlichen Diskurs mit einem vordefinierten 10-Dimensionen-Benchmark und bewertet jede Lücke nach Schweregrad und Implikation.

Belege:

Schritt 1: Benchmark erstellen Der theoretische Möglichkeitsraum wird in 10 Standarddimensionen für politische Debatten operationalisiert:

Dimension | Was sie abdeckt |

1. Rechtliche Ebene | Gesetze, Verfassung, Regulierung |

2. Soziale Ebene | Selbstzensur, Cancel Culture, soziale Kosten |

3. Ökonomische Ebene | Medienkonzentration, wer kann sich Öffentlichkeit leisten? |

4. Technologische Ebene | Algorithmen, Plattformen, KI-Moderation |

5. Historische Ebene | Entwicklungslinien, Vergleiche mit früheren Epochen |

6. Internationale Ebene | Vergleich mit anderen Ländern |

7. Akteursperspektiven | Wer spricht? Welche Rollen sind vertreten? |

8. Betroffenenperspektiven | Wer ist betroffen, aber nicht am Tisch? |

9. Lösungsebene | Konkrete Handlungsvorschläge |

10. Metaebene | Wer profitiert von der Debatte selbst? |

Schritt 2: Abdeckung messen Für jede Dimension wird der Abdeckungsgrad bewertet: nicht / kaum / mittel / hoch / sehr hoch.

Schritt 3: Lücken bewerten Jede Lücke erhält einen Schweregrad basierend auf zwei Fragen:

Wie relevant ist die Dimension für das Thema?

Hätte ihre Berücksichtigung zu anderen Schlussfolgerungen geführt?

Schritt 4: Vollständigkeitsindex berechnen Der Diskurs-Vollständigkeitsindex (0-1) aggregiert die Befunde zu einer Gesamtbewertung.

Welche Lücken fanden Sie in der Meinungsfreiheits-Debatte bei Markus Lanz?

TL;DR: Die Sendung "Markus Lanz" vom 27.11.2025 erreichte einen Vollständigkeitsindex von 0.42 – moderat unvollständig, mit sechs Lücken hohen Schweregrads.

Belege: Abdeckungsmatrix

Dimension | Abdeckung | Hauptsprecher |

Rechtliche Ebene | ●●●●● Sehr hoch | Brosius-Gersdorf |

Soziale Ebene | ●●●●● Sehr hoch | Precht, Meiritz |

Ökonomische Ebene | ○○○○○ Nicht | — |

Technologische Ebene | ●●●○○ Mittel | Brosius-Gersdorf |

Historische Ebene | ○○○○○ Kaum | — |

Internationale Ebene | ●●●●○ Hoch | Meiritz (USA) |

Akteursperspektiven | ●●●○○ Mittel | Alle |

Betroffenenperspektiven | ○○○○○ Nicht | — |

Lösungsebene | ●○○○○ Kaum | Marinić (kritisiert Fehlen) |

Metaebene | ●●●○○ Mittel | Marinić |

Identifizierte Lücken mit hohem/sehr hohem Schweregrad:

Betroffenenperspektive "von unten" (Sehr hoch)

Wer schweigt tatsächlich – und warum? Keine empirischen Daten, keine Betroffenen am Tisch.

Ökonomische Dimension (Hoch)

Wer kann sich Meinungsäußerung leisten? Medienkonzentration, prekäre Arbeitsverhältnisse im Journalismus – vollständig ausgeblendet.

Ungeprüfte 46%-Statistik (Hoch)

Die Prämisse der Sendung ("nur 46% fühlen sich frei") wird als Fakt gesetzt, nicht als These geprüft. Keine Quellenangabe, kein historischer Vergleich.

Minderheiten als Objekte (Hoch)

Über "migrantische Männergruppen im Stadtbild" wird geredet – nicht mit ihnen. Minderheiten sind Gegenstand, nicht Teilnehmer der Debatte.

Konkrete Lösungsvorschläge (Hoch)

Viel Diagnose, kaum Handlungsempfehlung. Marinić kritisiert das explizit, aber die Lücke bleibt.

Strukturelle Machtfragen (Hoch)

"Soziale Kosten" werden individualisiert (z. B. Shitstorm, Karriererisiko). Die strukturellen Bedingungen (Plattformmonopole, Verlagskonzentration) bleiben unsichtbar.

Wie interpretiere ich den Diskurs-Vollständigkeitsindex?

TL;DR: Der Index (0–1) zeigt, wie viel des theoretischen Möglichkeitsraums eine Debatte abdeckt – wobei 1.0 (100%) praktisch unerreichbar ist und 0.5 (50%) bereits eine solide Breite signalisiert.

Evidence

Wertebereich | Interpretation |

0.80 – 1.00 | Umfassende Debatte (selten erreichbar) |

0.60 – 0.80 | Weitgehend vollständig mit akzeptablen Lücken |

0.40 – 0.60 | Moderat unvollständig – systematische Lücken vorhanden |

0.20 – 0.40 | Erhebliche Lücken – Schlussfolgerungen möglicherweise verzerrt |

0.00 – 0.20 | Stark eingeschränkter Diskurs |

Die Lanz-Sendung erreichte 0.42 – das entspricht "moderat unvollständig". Für eine 60-Minuten-Talkshow ist das kein ungewöhnlicher Wert.

Der Index ist kein Qualitätsurteil über die Sendung, sondern ein Transparenzinstrument. Er zeigt, welche Perspektiven fehlen – nicht, ob die Sendung "gut" oder "schlecht" war.

Kritisch wird es, wenn Lücken mit hohem Schweregrad systematisch in eine Richtung weisen. In diesem Fall: Die fehlenden Perspektiven (Ökonomie, Betroffene, Strukturen) hätten tendenziell die "Chilling Effect"-These relativiert.

Wer profitiert von narrativen Lücken? {#cui-bono}

TL;DR: Systematische Lücken sind nie neutral – sie verschieben die diskursive Schwerkraft zugunsten bestimmter Narrative und Akteure.

Belege: Im Fall der Meinungsfreiheits-Debatte:

Lücke | Wer profitiert | Wie |

Keine Betroffenen am Tisch | Privilegierte Sprecher | Ihre Erfahrung wird zur Norm |

Ökonomie ausgeblendet | Status-quo-Verteidiger | Strukturkritik entfällt |

46%-Statistik ungeprüft | "Einschränkungs"-Narrativ | Prämisse bleibt unhinterfragt |

Lösungen fehlen | Krisenbeschreiber | Problem-Framing dominiert |

Das ist keine Verschwörung, sondern ein emergentes Muster: Gästeauswahl, Zeitdruck und redaktionelle Routinen erzeugen systematische Lücken, ohne dass jemand sie bewusst plant.

Discourse Gap Analysis macht diese Muster sichtbar – nicht um zu skandalisieren, sondern um Reflexion zu ermöglichen.

Für Medienbeobachter: Wenn dieselben Lücken über mehrere Sendungen hinweg auftreten, ist das ein strukturelles Signal.

Wie unterscheidet sich eine Discourse Gap Analysis von einer klassischen Medienanalyse?

TL;DR: Klassische Analyse fragt "Was wurde wie gesagt?" – Discourse Gap Analysis fügt hinzu: "Was wurde nicht gesagt, und welche Schlüsse wären sonst möglich gewesen?"

Belege

Dimension | Klassische Diskursanalyse | Discourse Gap Analysis |

Fokus | Gesagtes | Gesagtes + Ungesagtes |

Methode | Inhaltsanalyse, Framing | Benchmark-Vergleich |

Output | Cluster, Narrative, Positionen | + Lücken, Vollständigkeitsindex |

Frage | "Was wurde gesagt?" | "Was wurde nicht gesagt – und warum ist das wichtig?" |

Stärke | Tiefe Analyse des Gesagten | Strukturelle Blindstellen aufdecken |

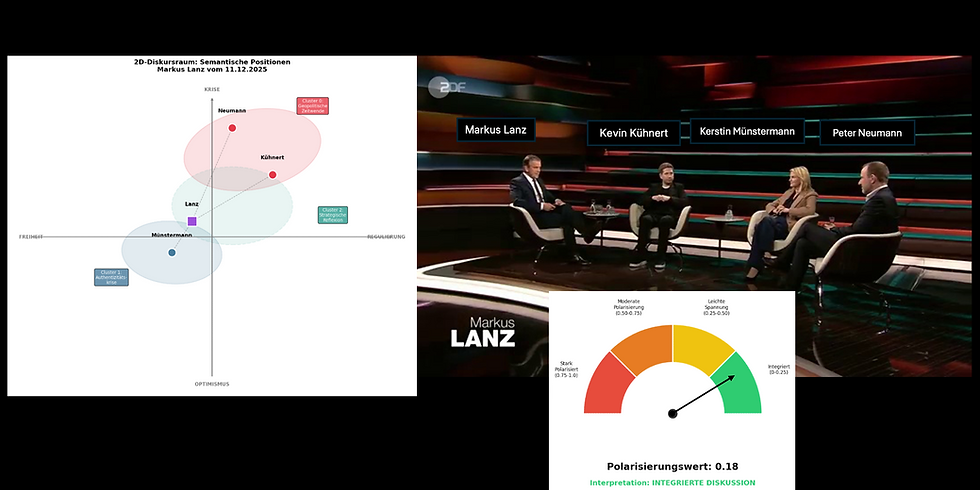

Beide Methoden ergänzen sich: Unsere Lanz-Analyse kombiniert semantische Cluster-Analyse (Was wurde gesagt?) mit Discourse Gap Analysis (Was fehlt?).

Die Kombination ist mächtiger als jede Methode allein: Cluster zeigen die Positionen im Raum; Lückenanalyse zeigt die Grenzen des Raums.

Wie kann ich Discourse Gap Analysis für meine Arbeit nutzen?

TL;DR: Die Methode eignet sich für die systematische Medienbeobachtung, die Kampagnenplanung, die Forschung und die redaktionelle Selbstreflexion.

Belege

Anwendungsfelder:

Medienbeobachtung / Monitoring

Systematische Analyse, welche Perspektiven in der Berichterstattung zu einem Thema fehlen

Frühwarnsystem für einseitige Diskurse

Kommunikationsstrategie

Identifikation von "weißen Flecken" im öffentlichen Diskurs

Positionierung in unterbesetzten narrativen Räumen

Wissenschaftliche Forschung

Quantifizierbare Methode für Diskursvollständigkeit

Vergleichbarkeit über Sendungen/Medien/Zeiträume

Redaktionelle Selbstreflexion

Prüfung der eigenen Gästeauswahl und Themenrahmung

Identifikation systematischer Blindstellen

Voraussetzungen:

Vollständiges Transkript mit Sprecher-Labels

Definierter Benchmark (wir stellen den 10-Dimensionen-Standard bereit)

KI-gestützte Analysefähigkeit oder manuelle Codierung

FAQ

Ist ein niedriger Vollständigkeitsindex automatisch schlecht? Nein. Eine 60-Minuten-Sendung kann nicht alles abdecken. Kritisch wird es erst, wenn Lücken systematisch in eine Richtung weisen und alternative Schlussfolgerungen verhindern.

Kann jede Debatte den vollen Möglichkeitsraum abdecken? Praktisch nie. Ein Index von 0.6-0.7 ist bereits sehr gut. Der Wert zeigt Transparenz, nicht Perfektion.

Wer definiert den Benchmark? Der 10-Dimensionen-Benchmark ist ein Vorschlag für politische Debatten. Er kann themenspezifisch angepasst werden.

Ist die Methode objektiv? Sie ist systematisch und transparent, aber nicht wertfrei. Die Auswahl der Dimensionen und Schweregrade enthält Urteile – die jedoch explizit gemacht werden.

Wie aufwändig ist eine Discourse Gap Analysis? Mit KI-Unterstützung: 2-4 Stunden für eine vollständige Sendung inkl. Transkription. Manuell: deutlich länger.

Kann ich die Methode auf Print/Online-Artikel anwenden? Ja, mit Anpassungen. Der Benchmark bleibt gleich, die Anwendung auf Einzeltexte oder Artikel-Korpora ist möglich.

Gibt es Branchen-spezifische Benchmarks? Noch nicht standardisiert. Wir entwickeln aktuell Varianten für Wirtschaftsberichterstattung und Wissenschaftskommunikation.

Methode & Datenanhang

Datengrundlage

Vollständiges Transkript der Markus-Lanz-Sendung vom 27. November 2025 (ca. 12.000 Wörter)

Thema: "Frei reden, aber richtig" – Meinungsfreiheit in Deutschland

Gäste: Richard David Precht, Frauke Brosius-Gersdorf, Jagoda Marinić, Annett Meiritz

Methodik

Benchmark-Definition: 10-Dimensionen-Standard für politische Debatten (siehe Abschnitt Methodik)

Abdeckungsbewertung: Qualitative Codierung jeder Dimension (5-Punkt-Skala)

Schweregrad-Bewertung: Kombination aus Relevanz (1-5) und Implikation für Schlussfolgerungen

Index-Berechnung: Gewichteter Durchschnitt der Abdeckungswerte

Limitationen

Die Schweregrad-Bewertung enthält qualitative Urteile

Der 10-Dimensionen-Benchmark ist ein Vorschlag, kein abschließender Standard

Einzelsendungen haben strukturelle Grenzen (Zeit, Gästezahl)

Vollständige Analyse

Die komplette semantische Diskursanalyse inkl. Cluster-Karte, Distanzmatrix und Visualisierungen ist verfügbar unter: /blog/markus-lanz-meinungsfreiheit-analyse

Discourse Gap Analysis für Ihre Medienbeobachtung

Sie möchten systematisch analysieren, welche Perspektiven in der Berichterstattung zu Ihrem Thema fehlen?

Wir bieten:

Einmalige Analysen einzelner Sendungen oder Artikel-Korpora

Laufendes Monitoring mit Lücken-Tracking über Zeit

Workshops zur Methodik für Redaktionen und Forschungsteams